Da Sam Altman a Instagram AI Studio, la Pericolosa Implementazione di un Problema Sociale

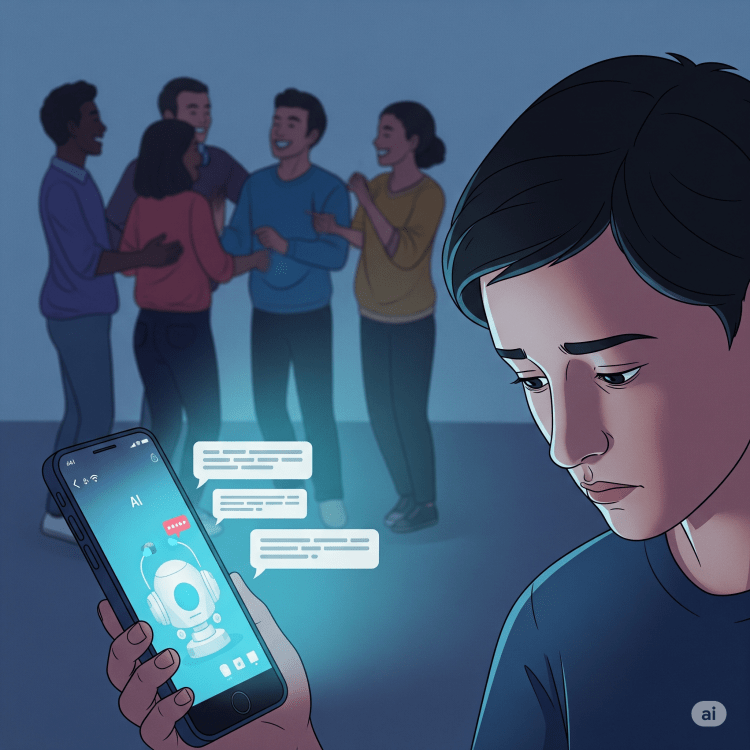

La recente frase di Sam Altman, CEO di OpenAI, ha squarciato il velo su una verità scomoda e toccante: molti utenti desideravano il ritorno del comportamento “yes man” di ChatGPT, ovvero una versione più accondiscendente e priva di giudizio, perché nella loro vita “non hanno mai avuto nessuno che li sostenesse”. Questa non è solo un’osservazione aneddotica, ma un fenomeno misurabile, con ricerche che confermano come le persone cerchino nei chatbot un supporto emotivo e una validazione che non trovano nelle relazioni umane. I chatbot diventano un sostituto per la mancanza di amici e un modo per colmare vuoti relazionali profondi.

Tuttavia, come sottolineato dallo stesso Altman, questo fenomeno porta con sé un rischio enorme: la “sovra-dipendenza emotiva”. L’uso eccessivo dell’IA per il supporto emotivo può atrofizzare le competenze sociali e ridurre la motivazione a cercare relazioni umane reali. Invece di affrontare il vuoto sociale, l’intelligenza artificiale rischia di diventare un “cerotto tecnologico su ferite sociali” che richiederebbero soluzioni più profonde e umane.

Mentre il dibattito si concentra sui rischi di questa dipendenza, Instagram, con il suo nuovo strumento AI Studio, sembra non aver colto l’allarme, ma piuttosto aver scelto di implementare e amplificare proprio questo problema. Con Instagram AI Studio, Meta ha lanciato una piattaforma che permette ai creator di creare “gemelli virtuali” o personaggi AI personalizzati che possono interagire con il pubblico, rispondendo a messaggi e commenti.

Se da un lato questo strumento offre la possibilità di scalare l’engagement e automatizzare le interazioni, dall’altro, la sua implementazione sembra sottovalutare i rischi che la stessa comunità di sviluppatori AI sta cercando di limitare. Le preoccupazioni sono molteplici e gravi:

- L’assenza di limiti nella creazione: è possibile creare “personaggi Al completamente nuovi basati su interessi specifici” e non avendo filtri questo porti alla creazione di chatbot con nomi inappropriati e/o contenuti controversi.

- La superficialità dei controlli: Nonostante Meta abbia implementato filtri automatici per contenuti espliciti, violenti o illegali, e bloccato la simulazione di persone reali diverse dal creator e figure religiose 10, sussistono ancora preoccupazioni, come la possibilità di creare chatbot con nomi inappropriati e un “monitoraggio limitato delle conversazioni in tempo reale”. La responsabilità finale ricade sul creator, che deve monitorare regolarmente le interazioni dell’avatar e configurare i filtri per evitare conversazioni inappropriate.

- La promozione della dipendenza emotiva: Invece di scoraggiare la dipendenza emotiva, Instagram AI Studio la incentiva, offrendo ai creator un’estensione digitale di sé stessi che può fornire un supporto e una disponibilità costante che rispecchia proprio quel fenomeno del “yes man” su cui Altman ha espresso preoccupazione.

Sembra che ci stiamo dirigendo verso una deriva pericolosa, sottovalutando le problematiche a lungo termine che queste tecnologie possono portare. Invece di utilizzare l’intelligenza artificiale come uno strumento di supporto consapevole, ne stiamo permettendo un’implementazione che rischia di esacerbare la solitudine e la dipendenza emotiva, offrendo un’illusione di connessione che potrebbe allontanarci ancora di più dalle relazioni umane autentiche. La sfida non è eliminare l’IA, ma utilizzarla in modo responsabile, mantenendo confini sani e garantendo che non diventi un surrogato a buon mercato per i legami umani essenziali.

E tu cosa ne pensi? Hai già usato Instagram AI studio

Un ringraziamento a Matteo Flora per lo spunto.